A regulação de IA está afobada no Brasil

Com referências nebulosas e sem norte concreto, dois projetos de lei em tramitação no Congresso podem dificultar o desenvolvimento da inteligência artificial no País, regulamentando o desenvolvimento tecnológico de pesquisadores e startups

“O Congresso entrou de vez no tema de inteligência artificial (IA). Pela Câmara, o projeto de lei (PL 21/2020), de autoria do deputado Eduardo Bismark e outros, quase entrou em regime de urgência para votação. Pelo Senado, o PL 872/21 do senador Veneziano Vital do Rêgo, avançou. Em comum, ambos projetos pretendem criar um tipo de “Marco Civil da Inteligência Artificial”, pegando carona em experiências internacionais, e tentando levar o Brasil para a frente do debate internacional. No entanto, com pouco debate, e com o Congresso semifechado devido à pandemia, estamos avançando com pouco cuidado em temas delicados.

Vale lembrar o exemplo tímido do Poder Executivo Federal, ao lançar a EBIA, a Estratégia Brasileira de Inteligência Artificial. Puxada pelo MCTI, a Estratégia chega depois de mais de 30 países terem lançado estratégias similares para inspirar. Mesmo com uma consulta pública de sucesso, com quase 1000 contribuições recebidas, a estratégia final publicada tem poucos elementos executivos. Faltou ao documento final estrutura, conteúdo e principalmente metas e estratégias.

Para conferir o nível de participar de cada setor da sociedade civil na elaboração da Estratégia Brasileira de Inteligência Artificial, clique aqui. Sobre o tema, a seguir listamos as limitações dos projetos de Lei no Congresso, que merecem atenção.

1. Esqueceram de ilustrar o que é inteligência artificial

Em regra, é bem-vinda a ideia de definir o que IA é ou deixa de ser. Há inspiração para ser seguida, em particular a definição dada pela OECD e pela União Europeia.

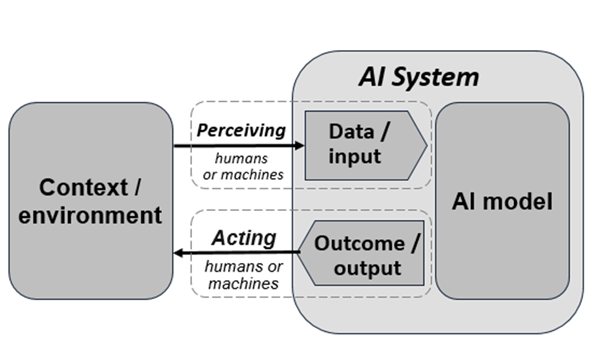

A definição da OECD é mais genérica, até porque se trata de um órgão multilateral que precisa encontrar o ponto de não discordância entre atores tão diferentes como os Estados Unidos, China e União Europeia. Foi essa a inspiração levada em consideração pelo PL 21/2020, que traduziu partes da definição da OECD, e a incluiu no texto de proposto como “sistema de inteligência artificial”.

Uma limitação do PL, contudo, foi ter se apropriado da definição em partes, e sem os necessários ajustes. A definição do PL é igual à da OECD, mas faltou ao PL incluir também a ilustração original (em destaque abaixo), exatamente aquela que associa a definição textual aos modelos criados pela IA. Ao adotar só o texto, sem o desenho, criamos uma definição de IA que é muito ampla, e que pode abarcar de tudo, de plataformas e soluções, do Microsoft Excel à pesquisa de conclusão de curso sobre jogos como TrackMania e machine learning.

Outro caminho do PL seria reaproveitar a definição da União Europeia, que vai além da OECD, e incluiu na definição da tecnologia uma lista de aplicações, como anexo. Como não temos como definir o que IA é, hoje, o uso de uma lista ilustrativa é essencial para orientar a regulação. Ao adotar o texto seco da OECD, perdemos esse referencial restritivo, e corremos o risco de ter uma barra de entrada baixíssima para o que IA seja.

2. Criam categorias de agentes de IA inspirados na LGPD

Uma das inovações do Congresso foi codificar o termo “agentes de inteligência artificial”. Enquanto nos marcos da OECD e da União Europeia esses agentes aparecem como atores, sempre misturados, por aqui o PL 21/2000 resolveu criar dois tipos de atores: um que desenvolve, e outro que faz uso das soluções de IA.

Os Agentes de Desenvolvimento têm traços semelhantes ao do Controlador na Lei Geral de Proteção de Dados (LGPD). Seriam aqueles que estão agindo diretamente sobre o design e concepção da IA, e teriam alto poder de decisão sobre como dados e modelos são criados. Já os agentes de operação seriam aqueles que operam a IA, e tem algum poder, mas menor.

É nobre a proposta de definir atores que lidam com IA, o que permite atribuir responsabilidades e direitos diversos. No entanto, ao contrário do marco regulatório de dados pessoais, no qual décadas de debate resultaram em conceitos como controlador, operador, e encarregado, nenhum país se aprofundou nesse tema.O resultado são conceitos de agentes que não foram testados na realidade. E com uma ebulição de tecnologias de IA tão grande, e um cenário tão transnacional de desenvolvimento, a proposição desse tipo de segmentação é temerosa. E os impactos são grandes, visto que atribuímos responsabilidades diretas a um tipo de agente ou outro.

3. Atribuem responsabilidades pesadas para inovadores

Há duas inovações no PL 21/2000 que colocam grande peso sobre quem pensa em desenvolver soluções em IA. Primeiro, se ampliam de forma diversa remédios para conter abusos de IA. Segundo, se atribuem responsabilidades e deveres amplos para quem trabalha com IA. Para as big techs, grandes empresas, esse é o caminho tomado pela União Europeia, e merece estudo e apreciação. Mas para pequenos inovadores, esse fardo regulatório tem o efeito de chilling effect. Ante os riscos, melhor não inovar.

O limite do Congresso aqui é ignorar que existem riscos diferentes, e para tanto, soluções regulatórias distintas. A União Europeia captou isso, e desenvolveu um sistema de regulação baseado em risco. Quanto maior o risco, maior o fardo. Mas quanto menor o risco, igualmente é menor o fardo.

Da forma como o PL propõe, qualquer comitê de ética da universidade terá sérios problemas para aprovar pesquisa sobre IA. Startups vão precisar de mais recursos financeiros iniciais para arcar com o mínimo necessário para entrar no mercado. No final, vamos acabar fortalecendo ainda mais a concentração de mercado, pois apenas os grandes competidores terão condição de permanecer vivos. Esse é o caminho inverso que leva o Brasil a ser potência em IA.

4. O fantasma da segurança pública

Ainda não aparecem nos marcos regulatórios propostos específicos sobre IA o debate entre dados pessoais e segurança pública. Contudo, o Brasil é um país no qual a violência faz parte do imaginário e da realidade de população, e é certo que volta e meia a tecnologia será vista como solução mágica para um problema complexo e estruturante.

Esse é o cenário perfeito no qual incentivamos uso massivo de tecnologia, sem pensar nas consequências ou na eficiência. O uso crescente por cidades que utilizam reconhecimento facial para encontrar procurados pela polícia, mesmo com as inúmeras evidências de baixa eficiência e de desrespeito ao cidadão, é um exemplo disso.

Algum debate foi incluído no anteprojeto da LGPD Penal. No entanto, sabemos que reconhecimento facial, vigilância em massa e privacidade são temas centrais na agenda regulatória. Não vai demorar para emendas ou novas propostas criarem a excepcionalidade da segurança pública e defesa nacional na regulação de IA no País. Esse é um risco que devemos evitar.

O Brasil patina ao adotar o modelo inspirado de regulação de dados pessoais europeu, a GDPR, que cria a exceção enquanto regulação de bloco para que países regulam os temas de segurança pública e defesa nacional por si mesmos. Por aqui, tiramos da LGPD o alcance desses temas, mas não avançamos na regulação de como o Estado usa dados pessoais em temas que envolvem polícias, inteligência e outros.

Ao mesmo tempo, muitos dos debates sobre IA e riscos recaem justamente sobre os temas de segurança pública e IA. Sem antes resolver o imbróglio de como permitimos o Estado a usar dados pessoais para alguns fins centrais, a regulação de IA vai andar de mãos atadas.

Como regular reconhecimento facial para fintechs sem distinguir do uso da tecnologia para vigilância em massa? Como regular uso de IA para compliance sem debater os limites de dados pessoais fornecidos por empresas públicas? Como pensar na contratação de tecnologia pelo Estado se algumas formas de uso terão regulação diferente? Por isso, o marco de IA deve, obrigatoriamente, aparecer abarcado por uma forte regulação de dados pessoais, ainda mais quando associado a temas de segurança e defesa.

Para onde devemos ir

O Brasil não é líder em inteligência artificial, mas tem potencial. Como demonstraram vários países, da China à Alemanha, da Dinamarca à Singapura, uma das chaves para o desenvolvimento de IA passa também por ações governamentais. Uma forte estratégia é o primeiro passo para pensarmos, em cinco anos, em colher os frutos.

Nada impede de pensarmos em marcos regulatórios de IA no Congresso. O perigo, contudo, é sufocarmos de vez o desenvolvimento de IA no país: ao criar obrigações que beneficiam indiretamente grandes empresas, sufocamos a inovação; ao criar definições amplas, levamos para o judiciário o caso de limitar o que IA é ou não, aumentando a insegurança jurídica; ao ignorar que não temos aindaLGPD Penal, reforçamos o abismo entre dados pessoais – como regras e dados pessoais – do Estado.

De qualquer forma, a regulação de IA no Congresso precisa de mais debate, e tempo. Afobada, corremos o risco de afogar aqueles que já se aventuraram a desenvolver IA no País, e de piorar os riscos que queremos evitar. O Congresso está criando responsabilidades pensando nas big techs, mas atingindo a academia e as startups; em vez de pensarmos na formação de lideranças, focamos nas punições.

Se qualquer um dos projetos passar no Congresso, da forma como estão, teremos um retrocesso no desenvolvimento de inteligência artificial no Brasil. Mais tempo, mais discussão, em tempos para além da pandemia, mostra-se necessário para pegar o melhor da inspiração internacional, como a regulação graduada por nível de riscos, como da União Europeia – ou da inspiração nacional – como a longevidade e visão da Lei do Marco Civil da Internet.

Gostou do artigo do Fabro Steibel saiba mais sobre regulação de inteligência artificial e de outras tecnologias assinando nossas newsletters e ouvindo nossos podcasts na sua plataforma de streaming favorita.“”

Leia também

O rio Estige da IA: fronteira entre conhecimento e sabedoria

O futuro da saúde está em tirar os hospitais do centro do atendimento

Conhecimento é poder? Hoje, só com letramento em IA

O que o mito da garagem não ensinou aos empreendedores

O império da personalização – e o que vem depois

Inteligência artificial: para onde caminha a humanidade?

Tecnologia para além do hype

Os desafios da identidade descentralizada